- Wissen

- Maschinelles Lernen

Der KI fehlt die Langeweile

Studien zur Kreativität von menschlichem Hirn und künstlichen Intelligenzen zeigen neue Möglichkeiten und neue Risiken

Wie kreativ sind eigentlich künstliche Intelligenzen? Fragt man dies ChatGPT, eine der derzeit am weitesten verbreiteten künstlichen Intelligenzen, ist die Antwort recht eindeutig. Maschinen seien »weniger flexibel und kreativ als Menschen, können aufgrund der schnellen Verarbeitung großer Datenmengen aber sehr effizient bei der Lösung spezifischer Aufgaben sein«, meint der Chatbot.

Man sollte ihm nicht alles glauben. Die am Max-Planck-Institut für Biologische Kybernetik tätige Kognitionsforscherin Surabhi Nath, die zuerst in der Hirnforschung aktiv war und jetzt auch kognitive Prozesse von maschinellen Intelligenzen untersucht, war an einer Vergleichsstudie zur Kreativität von insgesamt 220 menschlichen und 440 maschinellen Intelligenzen beteiligt. Dabei wurden die Parameter Flexibilität und Beharrlichkeit untersucht.

»Der Output war durchaus ähnlich«, erzählt Nath »nd.Die Woche«. In Sachen Beharrlichkeit – es ging darum, in nur zwei Minuten so viele Alternativbezeichnungen wie möglich für Ziegelstein und Büroklammer zu finden – gab es kaum Unterschiede. Bei der Flexibilität – in zehn Minuten sollten verschiedenste Ideen für das Nutzen dieser beiden Objekte gefunden werden; die Spannbreite reichte von Werfen bis Bauen – fanden die Forscher*innen heraus: »Es gab Menschen, die flexibler waren als andere, und künstliche Intelligenzen, die ihrerseits flexibler als andere agierten.« Kreativität ist also bei Menschen wie bei Maschinen ähnlich ungleich verteilt.

Mehr Daten machen flexibler

Interessant war allerdings, dass von den 440 künstlichen Intelligenzen, die die Forschungsgruppe der Max-Planck-Institute in Tübingen und Leipzig, der Uni Tübingen sowie der Uni Amsterdam untersuchte, lediglich acht überhaupt in der Lage waren, den Test auszuführen. Dazu gehörten unter anderem ChatGPT, Googles Chatbot Gemini, die von Aussteigern von OpenAI als Alternative zu ChatGPT entwickelte Claude AI sowie Llama AI vom Facebook-Konzern Meta.

Bei denen, die bei der Ziegelstein-Aufgabe vergleichsweise flexibel operierten, also semantische Sprünge machten, die man als Zeichen für Kreativität interpretieren kann, waren die Ergebnisse bei der Büroklammer-Aufgabe allerdings dürftiger. Menschen hingegen, die die erste der beiden Aufgaben kreativ lösten, gingen die zweite ähnlich kreativ an. Nath führt das auf folgende Gründe zurück: »Ziegelstein hatten wir ausgewählt, weil es dazu bisher die meisten Studien gibt. Büroklammer nahmen wir als Vergleich, weil Studien dazu nicht so weitverbreitet sind. Offenbar hatten die künstlichen Intelligenzen zu Ziegelstein einfach mehr Daten zur Verfügung und waren deshalb flexibler.«

Das bestätigt die gängige Annahme: Künstliche Intelligenzen sind für spezifische Aufgaben nur dann gut, wenn sie für genau diese mit einer Vielzahl von Daten trainiert wurden. Sind weniger Daten verfügbar, sind auch die Ergebnisse dürftiger.

Mit unserem wöchentlichen Newsletter nd.DieWoche schauen Sie auf die wichtigsten Themen der Woche und lesen die Highlights unserer Samstagsausgabe bereits am Freitag. Hier das kostenlose Abo holen.

Um einen Vergleich mit dem Menschen zu wagen: Die gegenwärtigen Sprachmodelle sind teilweise begabt, auf Gebieten, für die sie gut trainiert sind. Man sollte sie aber zumindest gegenwärtig nicht für Universalgenies halten, die auf alles die richtige Antwort haben. Und selbst wenn sie mit vielen Daten für das richtige Thema trainiert wurden, gibt es eine Menge Einschränkungen.

Eine ist: Sie lernen einfach nicht mehr dazu. Fragt man etwa OpenAIs kostenfrei verfügbare Version von GPT-4 nach dem eigenen Wissenshorizont, kommt heraus: »Mein Wissen basiert auf den Daten, die mir bis zu meinem letzten Training im Oktober 2023 zur Verfügung standen. Ich lerne im Moment nicht mehr dazu, nachdem mein Training abgeschlossen wurde. Das bedeutet, dass ich keine neuen Informationen aufnehmen oder mich weiterentwickeln kann, wie es ein Mensch tun würde.«

Feedback wird nicht berücksichtigt

Nur ein Update würde weiteres Wissen generieren. Und nicht einmal die in den Dialogen mit Nutzer*innen kreierten Inhalte stehen dem Chatbot später zur Verfügung: »Als AI-Modell, das auf einer festen Wissensbasis basiert, kann ich aus einzelnen Rückmeldungen oder Feedbacks im laufenden Gespräch nicht direkt lernen oder mein Wissen dauerhaft anpassen. Das bedeutet, dass ich die Informationen, die du mir gibst, während unseres Gesprächs berücksichtigen kann, aber diese Änderungen bleiben nur temporär und beeinflussen nicht mein zukünftiges Verhalten oder meine Wissensbasis.«

Auch die Lernprozesse zuvor, bei GPT-4 bis zum Oktober 2023, unterscheiden sich stark von denen des menschlichen Lernens. Ist bei Menschen das Feedback von außen, ein positiver oder auch negativer Kommentar zum gerade erfolgten Handeln als Steuerungsgröße relevant, so lernen die gegenwärtig verfügbaren Chatbots nur aus den Daten und den eigenen Mustererkennungsmethoden. GPT-4 erklärt den selbst erfahrenen Prozess des selbst überwachten Lernens so: »Ich habe aus großen Mengen an Textdaten gelernt, bei denen ich selbst ›Labels‹ oder Hinweise generiert habe, um Muster und Zusammenhänge zu erkennen.«

Das wäre auf menschliche Verhältnisse übertragen vergleichbar mit dem Anschauen eines Heimwerkervideos auf Youtube – ohne Feedback-Funktion –, wie man ein Dach deckt. Und dann macht man das auch selbst. Das kann funktionieren bei Leuten, die handwerklich trainiert sind wie Schreiner*innen oder Maurer*innen. Bei den Bauten der meisten anderen Personen würde man aber wohl ein Übernachten im Freien vorziehen.

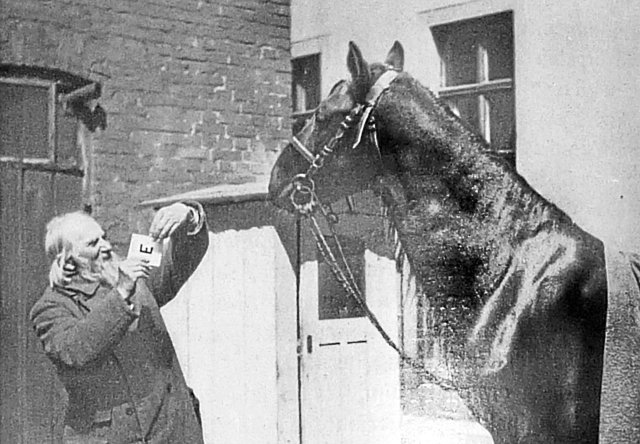

Die Grenzen des nicht überwachten und selbst überwachten Lernens machte kürzlich eine weitere Studie des Max-Planck-Instituts für Biologische Kybernetik deutlich. Systematische Fehler, die derart trainierten KIs unterlaufen, werden mittlerweile als »Kluger-Hans-Effekt« erforscht. Der Name geht auf ein Berliner Pferd im letzten Jahrhundert zurück, das angeblich rechnen konnte. Es zeigte die Lösung einfacher Mathematikaufgaben durch Klopfen mit dem Huf an. Eine wissenschaftliche Kommission stellte aber fest, dass der »kluge Hans« vor allem ein äußerst guter Beobachter war. Er las aus Körpersprache und Mimik der Fragesteller ab, wann beim Klopfen die richtige Lösung nahte, und setzte dann den – oft richtigen – letzten Akzent mit dem Huf.

»Die KI sollte ein Partner sein im Finden einer Lösung.«

Surabhi Nath Kognitionsforscherin

Bei künstlichen Intelligenzen ist das ähnlich. 2018 fand eine Forschergruppe aus Frankreich und Kanada heraus, warum eine Bilderkennungs-KI einige Huskys fälschlich als Wölfe identifizierte. Sie war mit Wolfsbildern im Schnee trainiert worden – und überall, wo jetzt ein Husky im Schnee zu sehen war, entdeckte die KI einen Wolf.

Das ist noch komisch. Eine Forschungsgruppe der TU Berlin stellte kürzlich allerdings fest, dass in der Medizin eingesetzte KI bei der Analyse von Röntgenbildern nicht nur die Bilder selbst analysierte, sondern auch daneben stehenden Text – was zu fehlerhaften Diagnosen führte.

Vorteile bestärkenden Lernens

Näher am üblichen Lernprozess des Menschen ist die Methode des bestärkenden Lernens. Dieses umfasst vor allem Feedback für Zwischenergebnisse, Lob und konstruktive Kritik. Der kanadische Psychologe und Computerwissenschaftler Richard Sutton plädiert schon länger für das Trainieren künstlicher Intelligenzen durch das bestärkende Lernen.

Vorteile wären laut Sutton: Weniger Daten sind zum Trainieren nötig, die Effektivität ist potenziell höher. Er bezeichnet das bestärkende Lernen als dritte Säule des Trainings von künstlichen Intelligenzen – neben dem unüberwachten Lernen, das für frühe Datensammel-KIs typisch war, und dem aktuell dominierenden selbst überwachten Lernen.

Auch Max-Planck-Doktorandin Nath ist überzeugt von dieser Methode. »Wir machen das gerade! Wir versuchen, ein Modell zu entwickeln, um herauszufinden, was gute Belohnungen sein könnten«, erzählt sie. Sie forscht dabei zuerst am Menschen und hofft, diese Erfahrungen später auch auf künstlichen Sprachmodelle anwenden zu können. »Wie das dann genau funktioniert, müsste ein Ingenieur für maschinelles Lernen sagen. Aber meine Intuition sagt mir, dass bestärkendes Lernen immer wichtiger sein wird.«

Risiken der KI im Bildungsbereich

Als große Gefahr wird mittlerweile diskutiert, dass eigene kognitive Leistungen beim Einsatz von KI nicht nur zurückgehen, sondern ungenutzte Hirnareale sogar geschwächt werden können. Hirn- und Maschinenforscherin Nath sieht diese Gefahr auch. Für den Einsatz von KI im Bildungsbereich schlägt sie deshalb vor: »Man könnte die KI trainieren, nicht die finale Antwort zu geben, sondern eine Zwischenantwort. Sie sollte ein Partner sein im Finden einer Lösung.« Auch hier also ist das Feedback, der Dialog, eine entscheidende Komponente beim Lernen – und bei der Entwicklung von Kreativität.

Eines übrigens werden Menschen noch eine ganze Weile den KIs voraushaben, so Nath: Die kreativen Sprünge, die entstehen, weil Menschen sich langweilen und nach neuen Lösungen suchen. Übernächste Etappe für künstliche Intelligenzen ist nach dem bestärkenden Lernen womöglich die Entwicklung eines Konzepts von Langeweile als Auslöser für Kreativität.

Das »nd« bleibt. Dank Ihnen.

Die nd.Genossenschaft gehört unseren Leser*innen und Autor*innen. Mit der Genossenschaft garantieren wir die Unabhängigkeit unserer Redaktion und versuchen, allen unsere Texte zugänglich zu machen – auch wenn sie kein Geld haben, unsere Arbeit mitzufinanzieren.

Wir haben aus Überzeugung keine harte Paywall auf der Website. Das heißt aber auch, dass wir alle, die einen Beitrag leisten können, immer wieder darum bitten müssen, unseren Journalismus von links mitzufinanzieren. Das kostet Nerven, und zwar nicht nur unseren Leser*innen, auch unseren Autor*innen wird das ab und zu zu viel.

Dennoch: Nur zusammen können wir linke Standpunkte verteidigen!

Mit Ihrer Unterstützung können wir weiterhin:

→ Unabhängige und kritische Berichterstattung bieten.

→ Themen abdecken, die anderswo übersehen werden.

→ Eine Plattform für vielfältige und marginalisierte Stimmen schaffen.

→ Gegen Falschinformationen und Hassrede anschreiben.

→ Gesellschaftliche Debatten von links begleiten und vertiefen.

Seien Sie ein Teil der solidarischen Finanzierung und unterstützen Sie das »nd« mit einem Beitrag Ihrer Wahl. Gemeinsam können wir eine Medienlandschaft schaffen, die unabhängig, kritisch und zugänglich für alle ist.